Индустрия рекламы уже давно одержима желанием понять человеческое поведение. Здесь огромные возможности дают системы искусственного интеллекта, которые способны преобразовывать огромные объемы сложной, неоднозначной информации в понимание личного поведения потребителей рынка, напоминает AdAge, публикуя мнение Джейсона Джерсиновича из Havas. Есть почти 2 миллиарда пользователей Facebook по всему миру. Около 200 миллиардов твитов публикуется в Твиттере каждый год. Google обрабатывает 40,000+ поисковых запросов каждую секунду.

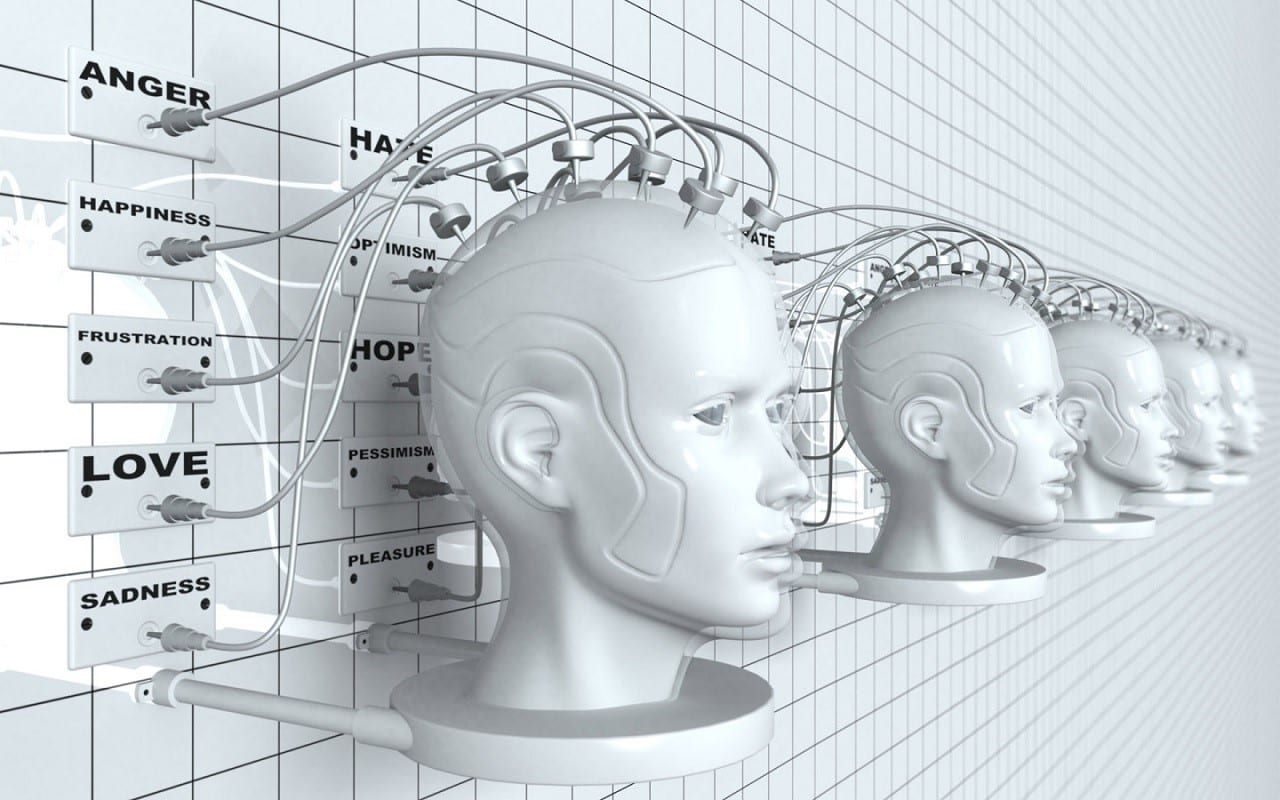

Теперь мы можем оценить всю полноту социальной активности личности: каждое слово, каждую картинку, каждый смайлик. Добавьте к этому данные о местоположении с мобильных телефонов, транзакционную информацию с кредитных карт и локальные наборы сведений, такие как новости и погода. Когда машинное обучение и алгоритмы анализа применяются в океане цифровой информации, мы можем глубоко изучить и понять мотивацию практически каждого потребителя.

Безусловно, это мощный инструмент, и никто не может обвинить рекламную индустрию, что она так быстро начала его применять.

Но использование AI также ведет к возникновению тревожных этических соображений. Рекламодатели вскоре могут узнать нас лучше, чем мы знаем себя сами. Они поймут больше, чем просто наши демографические показатели – они поймут наши самые личные мотивы и уязвимости. И есть опасность, что они могут использовать искусство убеждения и приемы из науки управления поведением.

Кроме этих страхов, есть и более практические соображения по практике применения машинного интеллекта в рекламе: данные могут быть предвзятыми, а алгоритмы способны вести к неправильным решениям и нарушать неприкосновенность личной жизни.

Поэтому нам нужен кодекс этики, который регламентировал бы использование AI в маркетинге и обеспечил бы прозрачность и доверие к нашей профессии.

Система доверия

Чем полнее наше понимание человека, тем более убедительным может быть маркетинг. Но каждый новый взгляд на потребителя порождает новые вопросы о наших моральных обязательствах – перед каждым человеком и перед обществом в целом.

Например, большинство соглашается, что приемлемо использовать AI для нацеливания на потребителя, который проявляет интерес к спортивным автомобилям. Но что, если при этом вы знаете, что потребитель погряз в долгах, не способен контролировать импульсы, часто нарушал правила безопасного вождения и злоупотреблял наркотиками и алкоголем? Неужели вы все еще в состоянии продать скоростной автомобиль этому человеку, зная, что на дороге будет невозможно от него спастись?

Вместо того чтобы судить каждый отдельный случай с моральной точки зрения, более эффективно было бы установить руководящие принципы, устраняющие подобные гадания. Система прозрачности, где потребитель скорее станет партнером в нацеленном на него маркетинге, а не невольной целью, – это будет настоящий этический путь вперед.

Такая система будет включать в себя три основных аспекта: данные, алгоритмы и выбор потребителей.

Данные: AI питается данными, которые используются для создания и обучения алгоритмов и поддержания системы. Если данные неточны или искажены каким-либо образом, эти недостатки будут отражены в решениях, принятых системой машинного интеллекта. Часто эти наборы данных отражают человеческие недостатки. Неудачный опыт Microsoft с ботом Тай, который начал воспроизводить агрессивную лексику тех, кто с ним общался, вероятно, является самым печально известным примером.

Алгоритмы: механизмы AI содержат коды, которые улучшают исходные данные. Они диктуют законы по которым работает система искусственного интеллекта, но они разработаны людьми и работают с ними тоже люди. Это означает, что их инструкции должны быть «объяснимыми». Некоторые называют это условие «алгоритмической прозрачностью». Прозрачность, однако, нереалистична в этом контексте, поскольку именно в алгоритме скрыта самая ценная интеллектуальная собственность AI, и агентства не хотят открыто делиться этим кодом. Кроме того, сложные системы машинного обучения могут быть черным ящиком, неспособным адекватно объяснить свое обоснование любого конкретного решения. Когда вы не знаете внутренних функций и преимуществ – рецепта подлинного доверия нет. Прозрачность означает обеспечение четкого объяснения причин выбора, которые делает AI.

Выбор потребителя: проще говоря, потребители должны быть осведомлены о способах, используемых на рынке для их привлечения, и иметь возможность участия в этих кампаниях. Чтобы сделать осознанный выбор, потребителю нужно четкое объяснение «меновой стоимости» в любой момент кампании. Что он делает? Что он получает взамен? И ему должно быть разрешено отказаться, если он почувствует свое нежелание в этом участвовать.

Мы рекламщики, а не специалисты по морали. Однако это не избавляет нас от необходимости рассмотрения социальных последствий работы, которую мы делаем. Мы знаем, что существует линия нашей деятельности, которая может – и, вероятно, будет – пересекаться с AI. Следовательно, мы должны разработать рекомендации по этике использования искусственного интеллекта в рекламе, и понять разницу между тем, что мы можем знать, должны знать и не должны знать.

Подробнее: https://adindex.ru/news/adyummy/2017/06/26/160535.phtml